李宏毅-机器学习2021春-1

李宏毅-机器学习2021春-1

1 机器学习基本概念

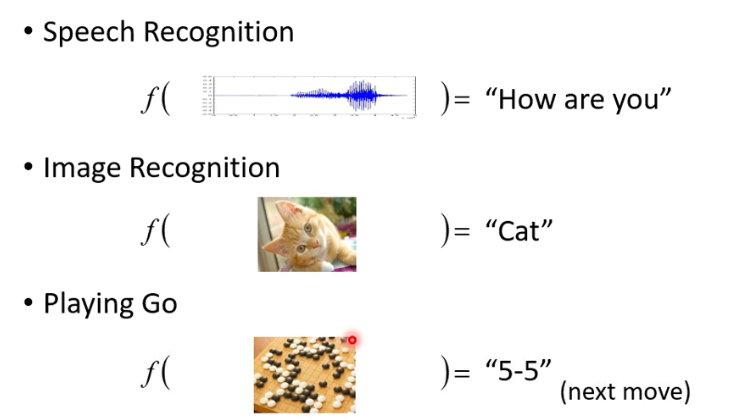

1.1 机器学习基本任务

机器学习的基本任务:寻找一个函数

不同种类的函数:

- Regression(回归):函数输出一个标量

- 如:预测PM2.5

- Clssificatiion(分类):给定选项,函数输出选项

- 如:Alpha Go下棋

- Structured Learning:创造一些结构(图片,文件)

1.2 通过训练数据定义Loss

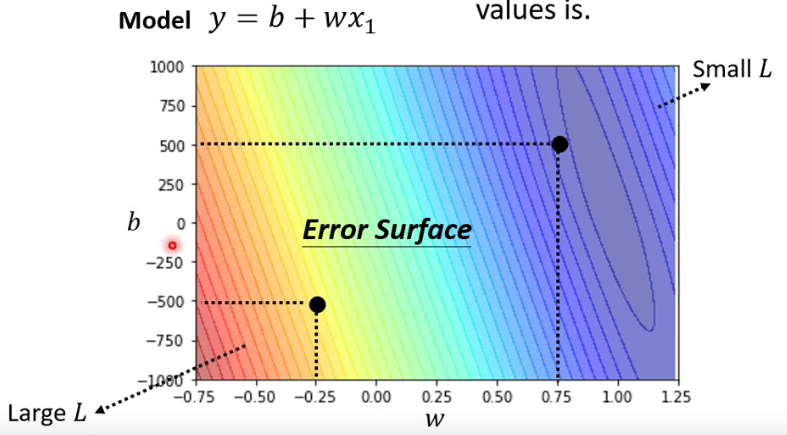

Loss 也是一个函数,它的输入是Model中的parameters: $$ L(b,w) $$

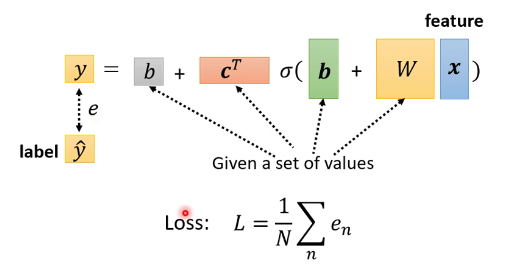

Loss function:$L=\frac{1}{N}\sum_ne_n$

- Mean Absolute Error(MAE):$e=|y-\hat{y}|$

- Mean Square Error(MSE):$e=(y-\hat{y})^2$

1.3 Optimization

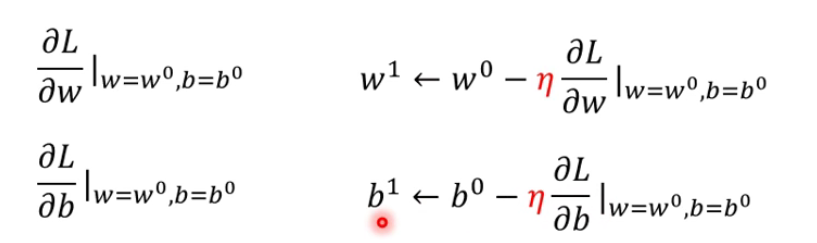

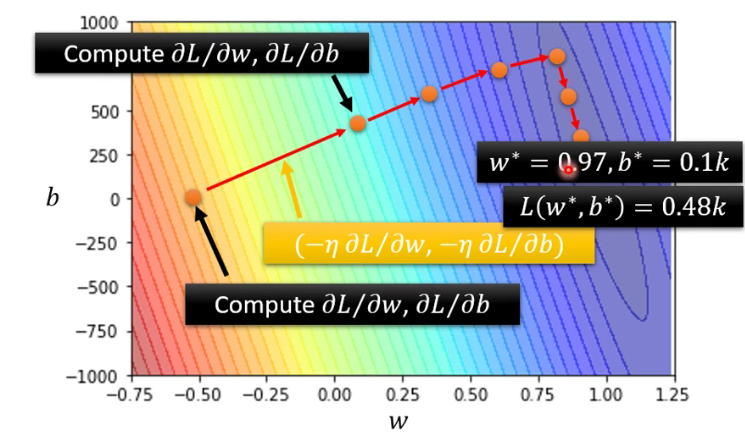

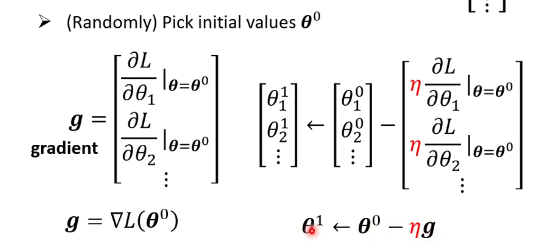

目标:得到最优的参数。 $$ w^{*}, b^{*}=\arg \min _{w, b} L $$ 方式:Gradient Descent

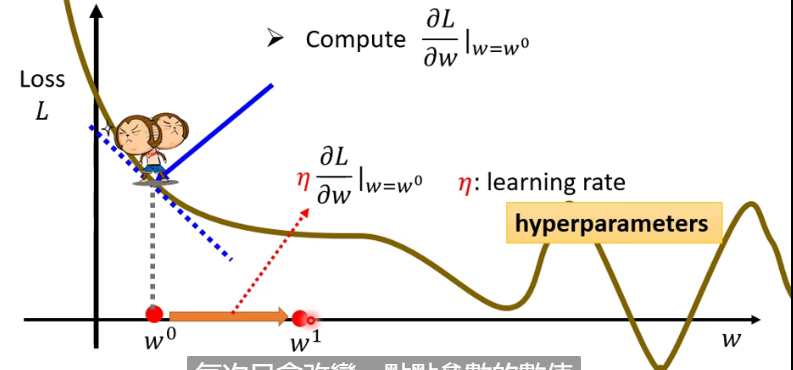

- 一个参数w的情况

- 随机选取初始值$w^0$

- 计算$\left.\frac{\partial L}{\partial \mathcal{\imath}}\right|_{w=w^{0}}$

- learning rate:$\eta$,表示梯度下降的速率

- 不断更新w:$w^{1} \leftarrow w^{0}-\left.\eta \frac{\partial L}{\partial w}\right|_{w=w^{0}}$

- 两个参数的情况:

2 深度学习基本概念

2.1 Function

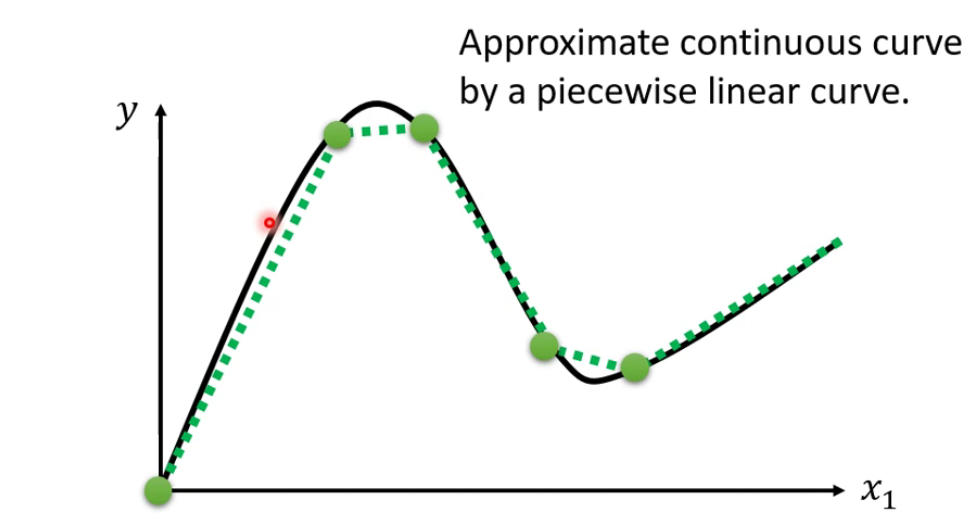

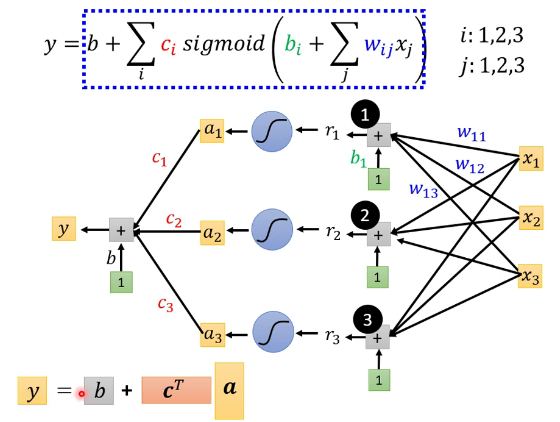

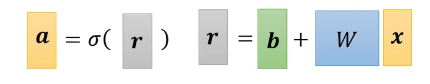

使用Piecewise Linear Curves逼近连续的曲线。

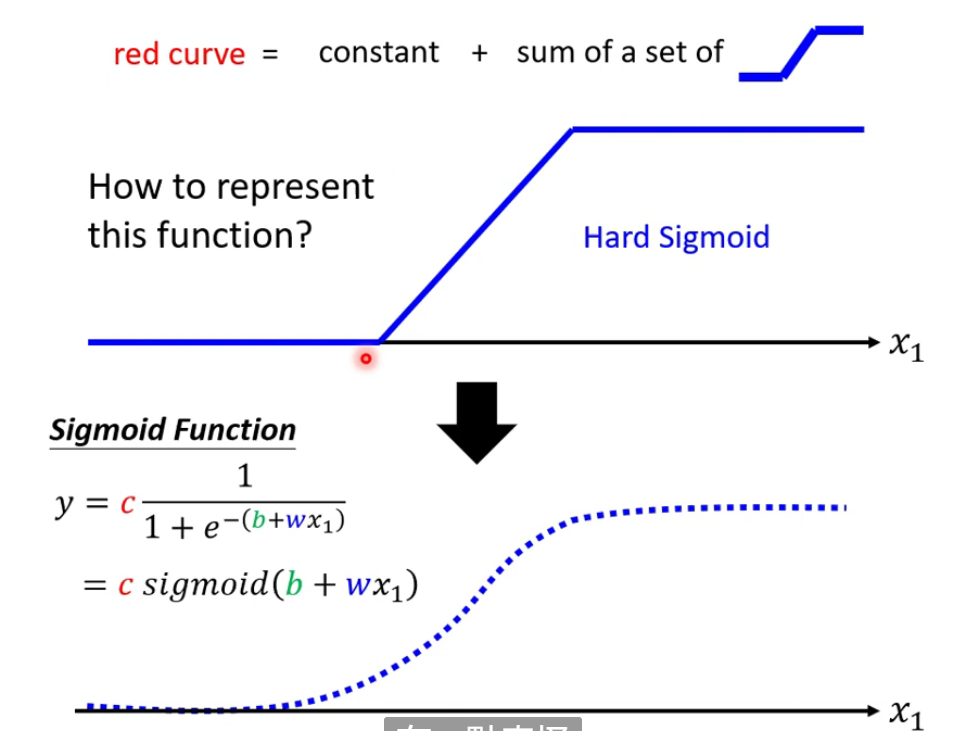

Piecewise Linear Curves = constant + Sigmoid函数

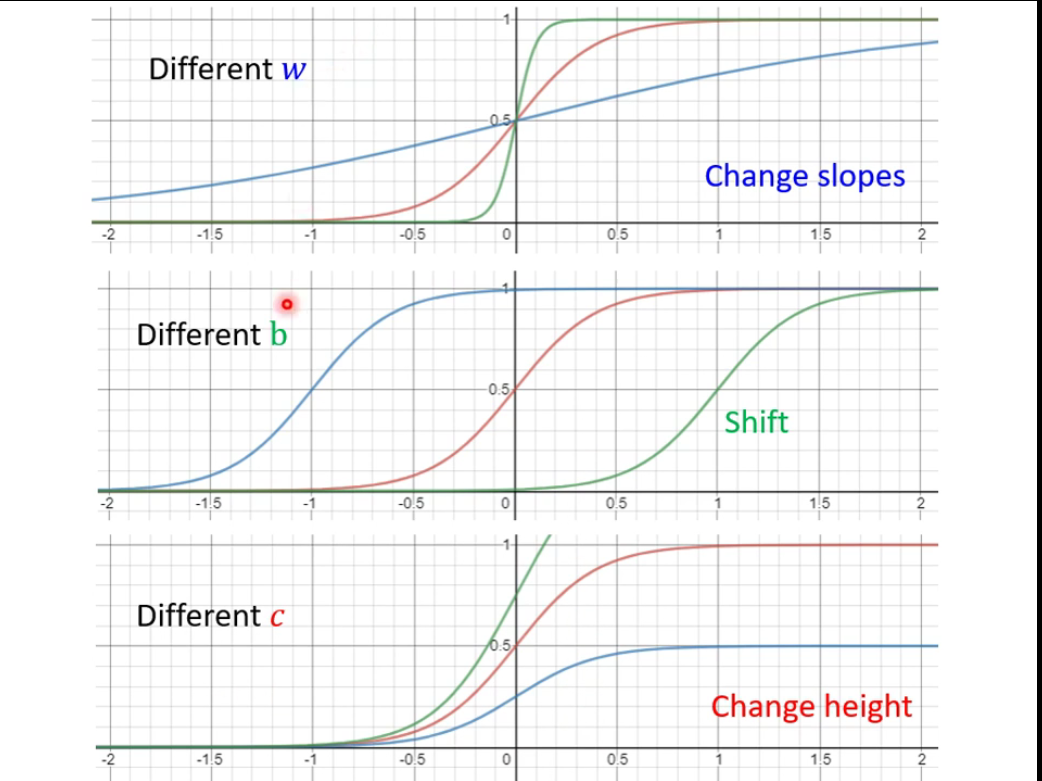

调整w、b、c,得到不同的Sigmoid Function

以此构造神经网络。

2.2 Loss

Loss:与之前相同,输入同样是一堆参数。

2.3 Optimization

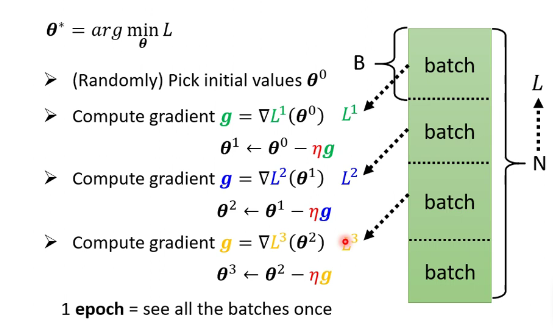

$$ \theta^*=arg min_\theta L $$

- 每次更新一次参数叫做一次update,吧所有的batch都看过以便叫做一个epoch。

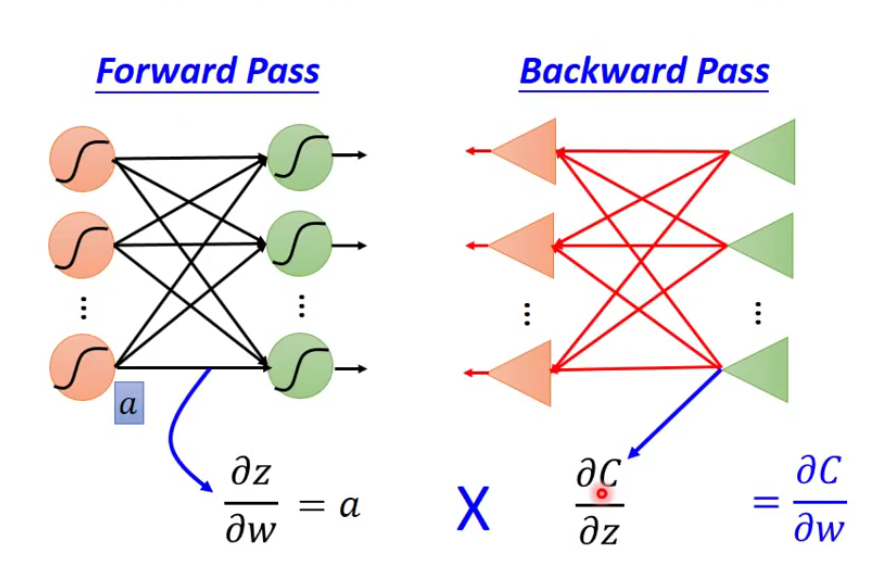

反向传播

从后往前计算偏导数,得到完整的梯度。

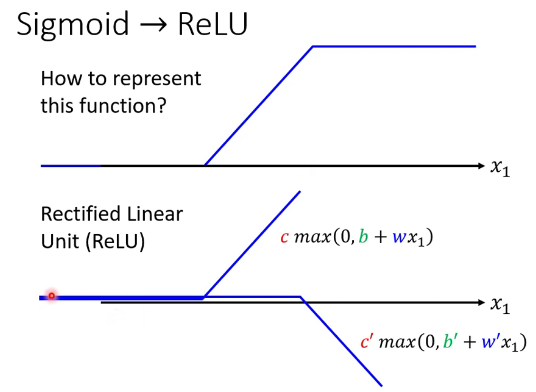

2.4 Sigmoid->ReLU

两个ReLu叠起来构成一个Hard Sigmoid。